网站扶植好了,当然是希望网页被搜索引擎收录的越多越好,但有时候我们也会碰到网站不需要被搜索引擎收录的情况。

比如,你要启用一个新的域名做镜像网站,主要用于PPC 的推广,这个时候就要想体例屏蔽搜索引擎蜘蛛抓取和索引我们镜像网站的所有网页。因为如果镜像网站也被搜索引擎收录的话,很有可能会影响官网在搜索引擎的权重,这必定是我们不想看到的成果。

以下枚举了屏蔽主流搜索引擎爬虫(蜘蛛)抓取/索引/收录网页的几种思路。注意:是整站屏蔽,并且是尽可能的屏蔽失落所有主流搜索引擎的爬虫(蜘蛛)。

1、通过 robots.txt 文件屏蔽

可以说 robots.txt 文件是最重要的一种渠道(能和搜索引擎成立直接对话)。我通过阐发我自己博客的办事器日志文件,给出以下建议(同时欢迎网友弥补):

User-agent: 百度spider

Disallow: /

User-agent: 谷歌bot

Disallow: /

User-agent: 谷歌bot-Mobile

Disallow: /

User-agent: 谷歌bot-Image

Disallow:/

User-agent: Mediapartners-谷歌

Disallow: /

User-agent: Adsbot-谷歌

Disallow: /

User-agent:Feedfetcher-谷歌

Disallow: /

User-agent: Yahoo! Slurp

Disallow: /

User-agent: Yahoo! Slurp China

Disallow: /

User-agent: Yahoo!-AdCrawler

Disallow: /

User-agent: YoudaoBot

Disallow: /

User-agent: Sosospider

Disallow: /

User-agent: Sogou spider

Disallow: /

User-agent: Sogou web spider

Disallow: /

User-agent: MSNBot

Disallow: /

User-agent: ia_archiver

Disallow: /

User-agent: Tomato Bot

Disallow: /

User-agent: *

Disallow: /

2、通过 meta tag 屏蔽

在所有的网页头部文件添加,添加如下语句:

<meta name="robots" content="noindex, nofollow">

3、通过办事器(如:Linux/nginx )配置文件设置

直接过滤 spider/robots 的IP 段。

小注:第1招和第2招只对"正人"有效,避免"小人"要用到第3招("正人"和"小人"别离泛指指遵守与不遵守 robots.txt 协议的 spider/robots),所以网站上线之后要不竭跟踪阐发日志,筛选出这些 badbot 的ip,然后屏蔽之。

这里有一个badbot ip 数据库:.spam-whackers/bad.bots.htm

4、通过搜索引擎提供的站长东西,删除网页快照

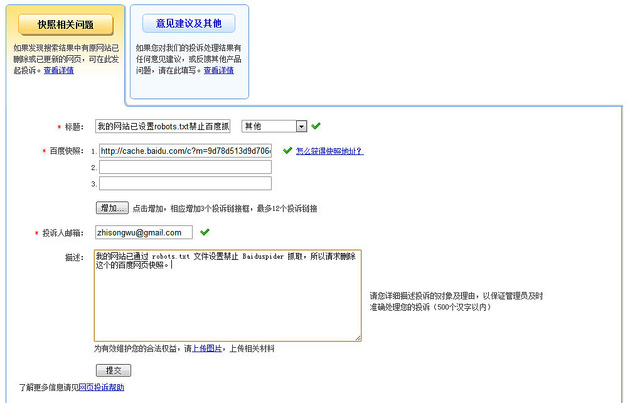

比如,有的时候百度不严格遵守 robots.txt 协议,可以通过百度提供的"网页投诉"入口删除网页快照。百度网页投诉中心:http://tousu.百度/webmaster/add

如下图是我的一个网页投诉:

年夜概3天左右的时间曩昔,这个网页的百度快照也被删除,说明此种体例也能起效,当然这是不得而为之,属于亡羊补牢。

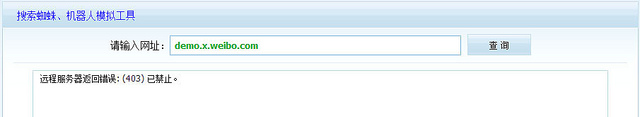

5、弥补更新

可以通过检测 HTTP_USER_AGENT 是否为爬虫/蜘蛛拜候,然后直接返回403 状态码屏蔽之。比如:由于api 权限与微博信息隐私庇护原因,Xweibo 2.0 版本后制止搜索引擎收录。

关于如何屏蔽搜索引擎爬虫(蜘蛛)抓取/索引/收录网页,您有其他什么更好的建议或体例,也欢迎颁发评论!期待与您交换。

本文作者:Bruce

原文地址:.wuzhisong/blog/67/

版权声明:欢迎转载,但必须以超链接体例注明本文原始出处!