站点的升级是每一个站点生命过程中不成缺少的一环。而如何措置升级过程中呈现的问题考验着每一个想成功的优化人员。在站点升级过程中我们难免会遇到死链接,尤其是哪一些收录量很年夜的站点。而这一些存在的死链接不但会严重影响到站点的权重,并且如果有年夜量的死链接会致使蜘蛛无法顺畅的爬行你的站点,最终致使的是收录和快照都跟不上。那么对因为改版而产生的死链接我们要如何妥善的措置呢?笔者今天就简单的分享自己的三点心得。

一:使用Robots.txt屏蔽或使用301重定向

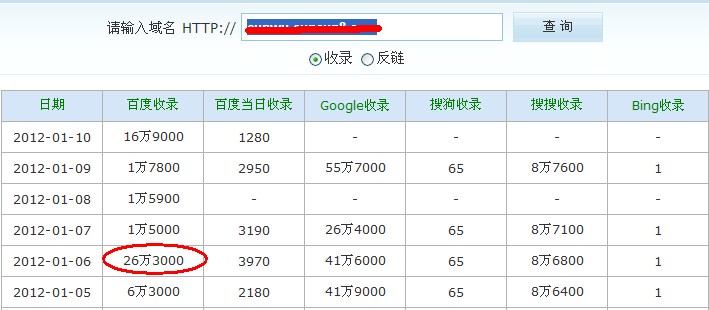

对这个别例是很多站长最长使用的体例之一。可是这个也会遇到一个问题,那就是如果你的站点的内容很庞年夜,就如笔者的站点,在改版升级之前收录有26万3000,如下图所示,能不克不及使用这两个别例呢?因为笔者的站点改版后,内容条理散布有改动,所以没体例用简单的Robots文件屏蔽,只能使用301重定向,可是这么年夜的收录量,使用这个别例是最耗时耗力的体例。

二:直接使用404毛病页面

这个别例对收录量年夜的站点仍是很有用的,将站点内部存在的死链接直接跳转到404毛病页面。然后通过404毛病页面将用户引导到改版后的压面。这样可以下降网站流量的流失,使得用户可以找到站点。对404页面的跳转时间的设置,笔者认为不要太短,最好在八秒到十秒左右,并且页面有引诱访客自行点击的链接,如下图所示,让用户自行点击会比直接跳转更好。

三:对峙内容的稳定更新

对一个刚升级的站点,稳定的进行内容的更新是至关重要的,这样不但可以快速的在升级后吸引到蜘蛛的爬行,并且也可让蜘蛛再次抓取旧的数据来进行替换。搜索引擎蜘蛛通常都是采纳广度优先,以超链接的形式来进行爬行站点。因此我们在稳定更新站点内容的同时也要公道的进行內链的构建,一步步稳定的吸引蜘蛛,达到重新收录内容,删除旧收录的信息的效果。

笔者认为对一个有着年夜量收录的站点来讲,最有效而直接的措置改版后年夜量的死链接的体例就是第二和第三。使用这两个别例不但可以下降权重的损失,并且也可以削减流量的流失。本文由贾学龙博客原创.jieyitonggo 转载请注明出处。