我们花操心思引来蜘蛛,无非是希望其索引网站。而一个可爬行新高的网站意味着蜘蛛索引极具深度及广度,从而也会使其为我们带来更多的收录及更平衡的权重。那如何成立一个高爬行性的网站呢?年夜禹总结通过以下五步提高网站的可爬行性。

一、网站条理布局

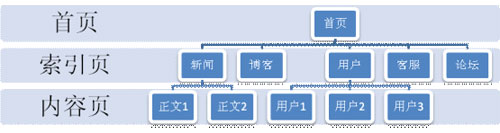

要利于蜘蛛爬行,首先得有一个清晰的条理布局。树形布局是比较抱负的网站布局,蜘蛛能够很好的理解并爬行。采取首页-索引页-内容页的形式有利于用户在最短的时间内找到需求的信息。并且由于相关性极强的内容在同一栏目下,提高了聚合度,这样更有利于蜘蛛的爬行整合。同时,树形布局应该遵循层数尽可能少的原则。

2、网站导航、次导航、面包屑

网站导航是网站不成或缺的重要组成部分。采取统一的导航栏不但有助于用户体验,更有助于蜘蛛识别。由于蜘蛛能有效识别并爬行css。因此,对导航栏字体使用font-weight属性是有效的。但切勿因为追求效果而采取js、ajax、inframe、flash等蜘蛛无法有效爬行的手艺。次导航同样可使用font-weight属性表白重要性,而面包屑导航也是必不成少的,要注意尽可能避免使用url链接,而更多采取锚文本链接。

三、内容页

新的内容应尽可能呈现在蜘蛛频繁更新的处所。因此,内容页应按ID或发布时间排序。而每篇内容页应和其他页面有效链接。可以在内容结束后插手上一篇、下一篇窜连上下篇文章。同时可以增加相关阅读、推荐阅读等栏目,这样更有助于蜘蛛索引。

四、标签、标签云

标签、标签云是提高聚合类内容可爬行性的有效途径。而标签云采取不合颜色、不合年夜小、不合粗细以区分不适用户存眷度的内容。因该说无论从用户体验仍是索引的主次都是有益的。但不该为追求标签云效果,而采取jquery等手艺,这样就失去了标签云的搜索引擎优化意义。

五、Sitemap

Sitemap文件对蜘蛛的索引是很重要的。Sitemap的制作不是本文讨论的重点。如果你的站点范围不是很年夜,请尽可能采取.xml格局,并放置于根目录下。百度sitemap东西正在内测中,因此暂时无法提交sitemap文件,我们只能采取提交网页的体例,提交新的页面。

百度:.百度/search/url_submit.html

谷歌:.谷歌/webmasters

成立一个高爬行性的内部链接系统,能把导入链接引来的蜘蛛索引有效的转化为收录和权重。因此,我们在做好外链的同时,不克不及轻忽了可爬行性这个重要因素。内外兼修,才能事半功倍。文章原创,转载请注明出处 幕墙设计 .788job ,谢谢!