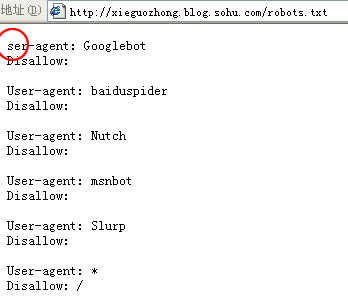

今天在某网站上看到这样一个帖子,由于搜狐博客的robots.txt文件在书写时时犯下一个初级毛病,少写一个字母U,致使搜狐博客被谷歌K失落。

试想辛辛苦苦在博客上做的外链,成果就由于法度员马虎年夜意,致使你的努力付之东流。没有比这更悲催的事情了。于是,年夜禹写下此文,以提醒站长朋友做外链时,切勿马虎年夜意,一定警戒以下外链隐形杀手。

杀手一:robots.txt

Robots.txt中disallow的URL将制止搜索引擎拜候,允许索引,显示搜索成果。知名的就是淘宝屏蔽百度蜘蛛。截止发稿,搜狐博客robots.txt文件毛病已修改。年夜禹相继查询了新浪、网易、搜狐、腾讯的博客频道的robots.txt文件,均未发现有屏蔽主流搜索引擎的行为。但年夜禹仍是得提醒搜索引擎优化er在做外链时,切忌先查询robots.txt文件,以免你的努力付之东流。

杀后二:nofollow

做搜索引擎优化的对nofollow一定不会陌生,nofollow是<a>标签中rel属性值,其允许拜候href属性的值,允许索引,显示成果,但不传递PR值,即不传递权重。今天年夜禹在A5上看到有帖子称国内某知名站长论坛对签名链接加了nofollow,经验证,纯属谣言。但可见站长对nofollow的发急。不传递权重的外链毫无意义,比较知名的就是网易博客设置了nofollow。

杀手三:js/ajax

这个对我们做友情链接显得尤其重要。这种js或ajax异法度用的链接毫无意义。但我们站长在做友链时往往疏于提防,仅仅凭肉眼看对方网站上是存在自己的链接。其实,通过专业的友情链接检测东西或查抄页面源文件中URL是否被标签包含就可以很容易的识别。

这个实际上是另外一种变相假链,和js挪用如出一辙。区别只是在于这个链接是存在的,但不在对方首页或友情链接页面。识别体例同js假链是一样的。